Twelve Labs, une startup qui développe des modèles d’intelligence artificielle pour l’analyse vidéo, a annoncé le lancement de son nouveau modèle Pegasus-1. Ce modèle est capable d’analyser des vidéos et de créer des rapports en fonction du contenu observé, de diviser des vidéos en sections logiques et d’effectuer d’autres tâches.

L’objectif principal de la startup est de former des modèles d’IA à résoudre des problèmes complexes de vidéo-texte. La société a été fondée pour créer une infrastructure pour la compréhension vidéo multimodale. Les produits de Twelve Labs diffèrent des grands modèles linguistiques comme ChatGPT en ce qu’ils sont créés et entraînés spécifiquement pour travailler avec la vidéo, combinant la capacité à travailler avec des composants visuels, audio et vocaux.

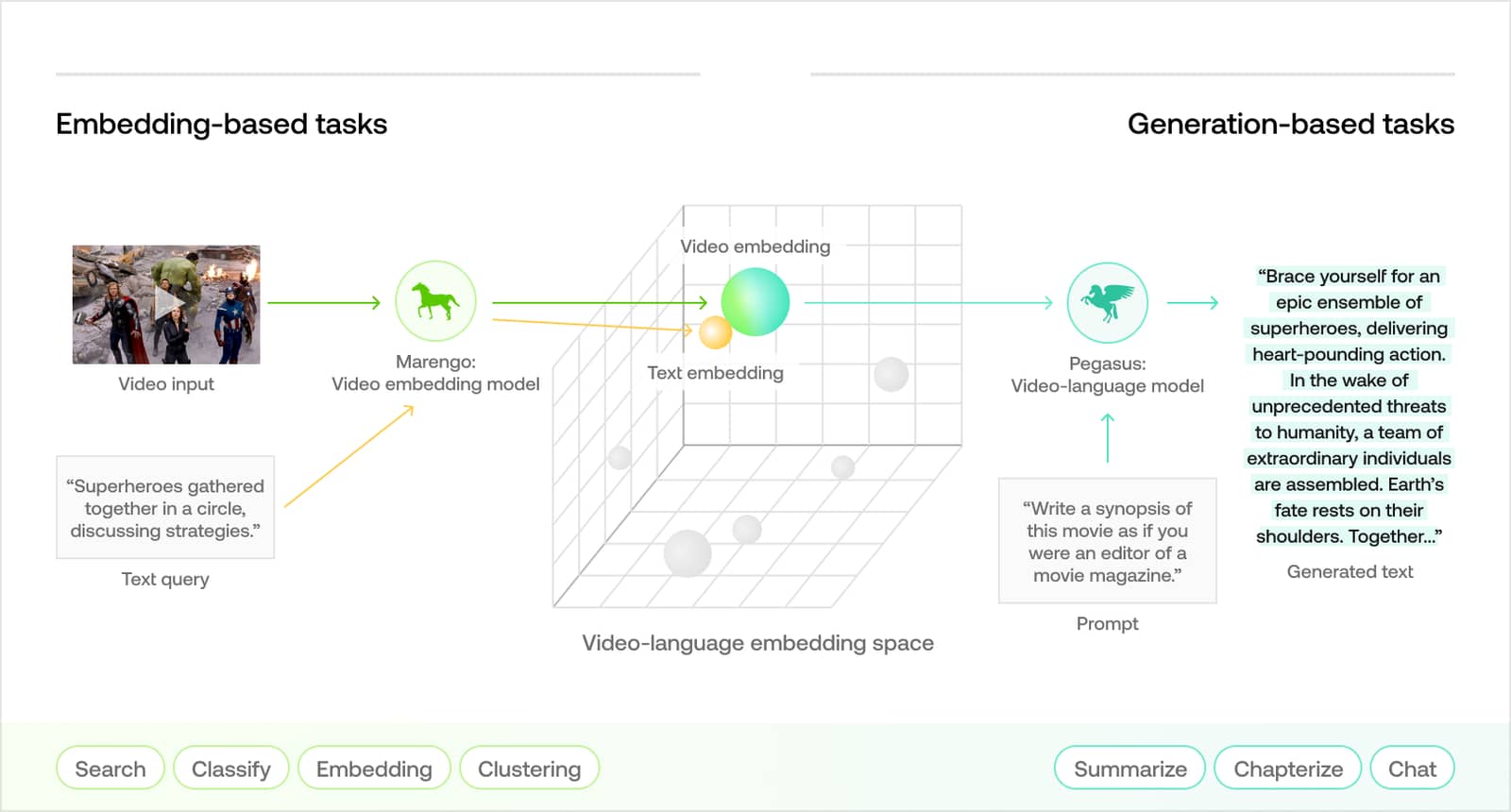

Les modèles de Twelve Labs visent à déchiffrer et à décrire en langage naturel le contenu des vidéos, y compris les actions, les objets et les sons de fond. Ces outils aident les développeurs à créer des programmes pour effectuer des recherches vidéo, transcrire du texte, résumer automatiquement, extraire des informations pertinentes, etc.

Une version bêta fermée du modèle Pegasus-1 a été lancée en mai de cette année. Le modèle a environ 80 milliards de paramètres et se compose de trois composants mutuellement apprenants : un encodeur vidéo, un modèle d’alignement texte-vidéo et un décodeur de langage. Pour entraîner Pegasus-1, l’équipe de la startup a utilisé 300 millions de vidéos diverses et sélectionnées à la main avec des transcriptions textuelles, ainsi qu’un milliard d’images avec des descriptions en langage naturel.

À l’heure actuelle, le modèle n’est pas encore disponible pour le public, mais une liste d’attente est disponible pour accéder à l’outil.

La technologie de Twelve Labs peut également être utilisée dans des domaines tels que la publicité et la modération de contenu vidéo. Par exemple, si une vidéo montre des couteaux, le modèle peut déterminer si la vidéo est du matériel pédagogique (programme de cuisine, etc.) ou contient des scènes de cruauté (vidéos de crimes, etc.). En outre, l’outil peut être utilisé pour l’analyse des médias et des tâches telles que la création automatique de titres de vidéos.

Twelve Labs n’est pas la seule startup à développer des modèles multimodaux pour l’analyse vidéo. Des entreprises comme Google, Microsoft et Amazon développent également des technologies similaires. Cependant, Twelve Labs affirme que ses modèles se distinguent par leur qualité et un ensemble plus large de fonctionnalités qui permettent aux clients d’effectuer des analyses vidéo plus détaillées en utilisant leurs propres données.

En plus de l’annonce du lancement de Pegasus-1, Twelve Labs a également annoncé la clôture d’un tour de table de financement, au cours duquel elle a levé 10 millions de dollars. Les investisseurs comprenaient Nvidia, Intel et Samsung Next.