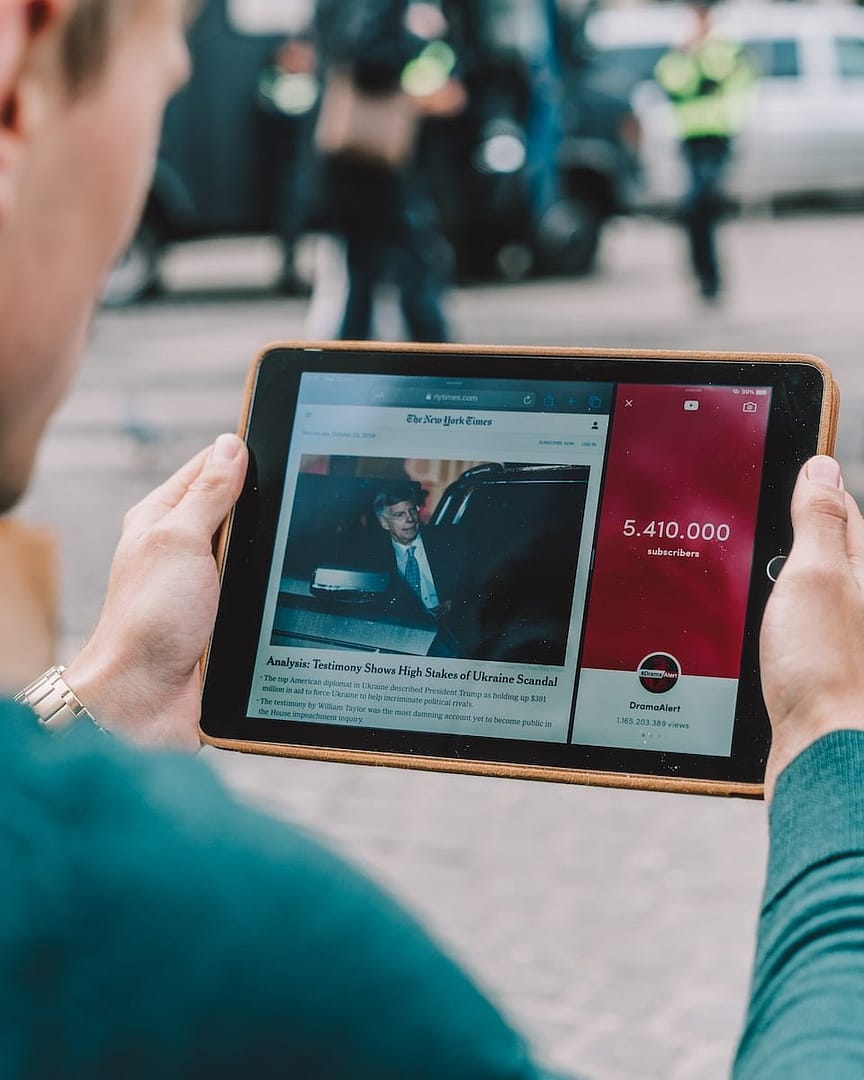

Le New York Times a récemment pris des mesures pour empêcher l’utilisation de son contenu à des fins d’entraînement des modèles d’intelligence artificielle (IA). Selon les informations d’Adweek, le 3 août, le NYT a mis à jour ses conditions d’utilisation afin d’interdire expressément l’utilisation de son contenu, incluant le texte, les photographies, les images, les extraits audio/vidéo, l’apparence et la sensation, les métadonnées ou les compilations, dans le développement de « tout logiciel, y compris mais sans s’y limiter, l’entraînement d’un système d’apprentissage automatique ou d’intelligence artificielle (IA) ».

Les nouvelles conditions spécifient également que les outils automatisés tels que les robots d’indexation de sites Web, conçus pour utiliser, accéder ou collecter ce contenu, ne peuvent être employés sans une autorisation écrite de la part de la publication. Le New York Times prévient que le non-respect de ces nouvelles restrictions pourrait entraîner des amendes ou des sanctions, dont les détails n’ont pas été spécifiés. Bien que le journal ait introduit ces règles nouvelles dans sa politique, il ne semble pas avoir modifié son fichier robots.txt, qui indique aux moteurs de recherche les URLs auxquelles ils sont autorisés à accéder.

Google s'est récemment accordé l'autorisation de former ses services d'IA sur les données publiques qu'il collecte sur le Web.

Cette décision pourrait être une réaction à la récente mise à jour de la politique de confidentialité de Google, révélant que le géant de la recherche collecte des données publiques du Web pour entraîner ses divers services d’IA, tels qu’Anthropic ou Cloud AI. De nombreux grands modèles de langage alimentant des services d’IA populaires, comme ChatGPT d’OpenAI, sont formés sur d’énormes ensembles de données susceptibles de contenir des contenus protégés par le droit d’auteur, ou obtenus du Web sans le consentement du créateur d’origine.

Toutefois, il convient de noter que le New York Times a également conclu un accord de 100 millions de dollars avec Google en février, autorisant le géant de la recherche à mettre en avant le contenu du Times sur certaines de ses plateformes au cours des trois prochaines années. Le journal a précisé que les deux entreprises collaboreraient sur des outils de distribution de contenu, d’abonnement, de marketing, de publicité et d’expérimentation. Par conséquent, il est possible que les modifications apportées aux conditions d’utilisation du NYT aient des implications plus larges, touchant d’autres entreprises telles qu’OpenAI ou Microsoft.

Ces nouvelles règles établies par le New York Times concernant l’utilisation de son contenu soulèvent diverses interrogations.

En interdisant spécifiquement l’emploi de son information à des fins d’entraînement de systèmes d’intelligence artificielle, le journal cherche avant tout à protéger sa propriété intellectuelle.

Cependant, les frontières restent floues quant à la définition même de données « publiques » pouvant être saisies par des robots d’indexation sur le web. Si le NYT continue d’autoriser ces robots à parcourir librement son site, n’est-ce pas contreproductif par rapport à son objectif affiché ? De plus, comment pourra-t-il vraiment s’assurer du respect de cette nouvelle politique et sanctionner d’éventuelles infractions ?

Une autre question sous-jacente porte sur l’équilibre à trouver entre l’open data et les droits des créateurs sur Internet. Si la presse demande davantage de transparence dans l’utilisation des données par les Gafam, ces dernières peuvent également faire valoir leur rôle dans le partage du savoir.

En définitive, c’est tout l’écosystème de l’information numérique qui se retrouve au coeur de tensions croissantes, entre intérêts commerciaux et besoins en régulation. Les accords au cas par cas promus par le NYT laissent entrevoir une voie médiane, mais des discussions plus globales sur ces problématiques apparaissent indispensable pour tous les acteurs concernés.